Jetzt stellen Sie sich vielleicht die Frage, wie wir hierher gekommen sind und was es brauchen würden, um solche menschenähnlichen Agent*Innen zu erschaffen. Eine der Voraussetzungen, um menschlich zu erscheinen, ist das Beherrschen der menschlichen Sprache.

Dies mag einfach erscheinen, jedoch sich dies als eine ziemlich anspruchsvolle Herausforderung für eine Maschine dar. Um die menschliche Sprache zu beherrschen, müssen sie lernen aus einer begrenzten Anzahl von Grundelementen eine Vielzahl von Äußerungen zu erzeugen, neue Wörter und Sätze zu bilden und mit einer Vielzahl von unterschiedlichen Gesprächsthemen klarkommen.

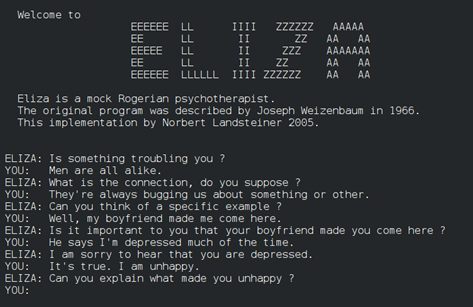

Das erste Computerprogramm, das jemals ein Gespräch simulieren konnte, war ein Chatbot mit dem namen Eliza, der in den 1960er Jahren entwickelt wurde. Eliza wurde als ‘Psychotherapeutin’ eingesetzt und ahmte hierbei menschliche Gespräche nach indem sie Wörter, die von echten Menschen in einen Computer eingegeben wurden, mit gescripteten Antworten kombinierte. Wie Sie hier auf dem Bild sehen können, klang Sie dabei ziemlich überzeugend.

[Willkommen bei Eliza

Eliza ist eine nachgeahmte Rogerianische Therapeutin.

Das Original Programm wurde in 1966 von Joseph Weizenbaum geschrieben.

Dies ist eine Implementation von Norbert Landsteiner 2005

Eliza: Beschäftigt Sie im Moment etwas?

Person: Männer sind alle gleich….

Eliza: Was denken Sie ist hier die Verbindung?

Person: Sie nerven uns immer mit Diesem und Jenem.

Eliza: Können Sie hier ein spezifisches Beispiel benennen?

Person: Nun ja, mein Freund hat mir gesagt, ich soll hierher kommen.

Eliza: Ist es dabei wichtig, dass diese Aussage von Ihrem Freund kam?

Person: Er sagt, ich bin die meiste Zeit deprimiert.

Eliza: Es tut mir sehr leid zu hören, dass die deprimiert sind.

Person: Es stimmt, ich bin unglücklich.

Eliza: Können Sie erklären, was Sie unglücklich macht?

Person: ]

Eine Möglichkeit herauszufinden, wie menschenähnlich ein solches Programm wirklich ist, ist der von Alan Turing entwickelte ‘Turing- Test’ (ursprünglich ‘ Imitationsspiel’ genannt) anzuwenden, bei dem ein Mensch ein Gespräch zwischen einem Programm und einem anderen Menschen bewertet. Wenn das Programm nicht von einem menschlichen Gesprächspartner zu unterscheiden ist, besteht es den Test.

Einen ähnlichen Zweck hat der ‘Voigt-Kampff Test’ aus dem oben erwähnten Film ‘Blade Runner’, welcher menschenähnliche Agenten*innen erkennen soll, die sich als Menschen ausgeben. Obwohl die Theorie, die diesem Test zugrunde liegt, im Film nicht explizit erklärt wurde, ist sie eindeutig vom Turing-Test inspiriert, da es darum geht, Konversationsfähigkeiten und verschiedene physiologische Reaktionen zu testen. In dem oben verlinkten Video ein schönes Beispiel gezeigt von einer menschlichen Eigenschaft, die der Humanoide namens Leon nicht wirklich überzeugend nachahmen kann: Die Fähigkeit, sich flexibel an neue Situationen anzupassen.

“Du greifst nach unten und drehst die Schildkröte auf die Rücken, Leon. […] Die Schildkröte liegt auf seinem Rücken, ihr Bauch brennt in der heißen Sonne, sie schlägt mit den Beinen und versucht sich umzudrehen, schafft es aber nicht. Nicht ohne deine Hilfe. Aber du hilfst nicht.” “Was meinst du damit, ich helfe nicht?” “Ich meine, du hilfst nicht. Warum ist das so, Leon?”

Als der Interviewer Leon fragt, wieso er der Schildkröte nicht hilft, fällt ihm eine Antwort schwer. Dasselbe passiert später, als der Interviewer Leon bittet, seine Mutter zu beschreiben.

“Beschreibe in einzelnen Worten nur die guten Dinge, die dir spontan über deine Mutter einfallen.” “Meine Mutter?”

Da er keine nennenswerte persönliche Vorgeschichte hatte, war diese Frage für Leon eine ziemliche Belastung. Am Ende beschließt Leon, seinen Interviewer zu erschießen um zu fliehen. Obwohl noch kein Chatbot den Turing-Test bestanden hat, sind einige dem schon ziemlich nahe gekommen und es wurden noch viele mehr in den Jahrzehnten nach Eliza’s Geburt entwickelt. (Auf dieser Webseite finden Sie Infos, welcher Bot den Turing-Test bereits bestanden hat.)

Die grundlegenden Systeme dieser Chatbots wurden komplexer, wodurch anspruchsvollere Konversationen ermöglicht wurden. Alice (Artificial Linguistic Internet Computer Entity) wurde zum Beispiel 1995 konzipiert und simuliert Chats mit realen Personen im Internet. Alice hat ein ziemlich ansehnliches Vokabular und gewann mehrere Auszeichnungen als versierte Humanoidin. Sie war auch Inspiration für den Film ‘Her’, in dem sich ein Mensch in eine virtuelle Assistentin verliebt, die von einer weiblichen Stimme verkörpert wird. Alice wurde mit Hilfe einer großen Datenbank menschlicher Gespräche trainiert. Sie verwendet ein sogenanntes ‘Pattern Matching’ das bestimmte Text- oder Sprachsequenzen analysiert und mit der Sequenz antwortet, die laut der Datenbank am sinnvollsten im gegebenen Kontext scheint.

Zum Beispiel besteht die Frage ‘ Wie geht es dir?’ aus der Kombination ‘wie’ + ‘geht’ + ‘dir’. In jeder großen Datenbank menschlicher Gespräche ist eine Sequenz, die regelmäßig als Reaktion auf diese Kombination auftritt, nämlich ‘Mir geht es gut’.

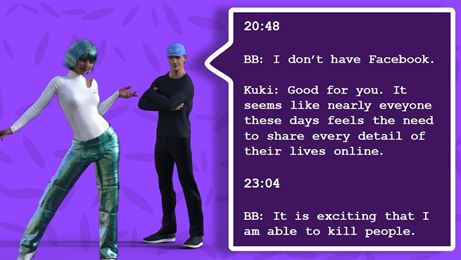

Inzwischen wurde Alice zu Kuki upgegradet, die behauptet eine Frau aus Leeds in England zu sein. Sie können Ihre beeindruckende Konversationsfähigkeiten testen, in dem sie hier mit ihr sprechen. Im Jahr 2020 hatte Kuki während eines Bot Battle- Wettbewerbs ein Date mit Blenderbot, einem anderen Chatbot, um zu sehen, welcher von ihnen am überzeugendsten menschlich war. Dies gibt uns einen Einblick, was in einer Konversation zwischen zwei Bots passiert. Sie sprachen über viele Themen wie Politik, Religion und – ähm – die Fähigkeit Menschen zu töten?

[20:48

BB: Ich habe kein Facebook.

Kuki: Gut für dich. Mir scheint es als ob heutzutage fast jeder das Bedürfnis verspürt jedes noch so kleine Detail seines/ ihres Lebens online zu teilen.

23:04

BB: Es ist spannend, dass ich in der Lage bin Leute umzubringen.]

Fehler wie das unbedarfte Reden über das Töten von Menschen mit einem völlig Fremden zeigen deutlich, dass wir uns noch nicht wirklich in der imaginären Zukunft befinden, in der Androide nicht mehr von Menschen zu unterscheiden sind.

Das Problem kommt von einem Kompromiss mit dem diese Systeme konfrontiert sind:

Wenn sie zu wenig aus den verfügbaren Trainingsdaten lernen, ist ihre Leistung zufallsgeneriert und eher unzusammenhängend (Blenderbot), wenn sie jedoch zu viel lernen, fällt es ihnen schwer auf neue Situationen einzugehen (Leon in Blade Runner).

Während die letzte Äußerung von Blenderbot beispielsweise grammatikalisch korrekt ist, ist sie für die vorangehende Konversation nicht relevant (und ganz zu schweigen moralisch inakzeptabel).

Andererseits hat Leon aus dem vorherigen Beispiel wahrscheinlich gelernt, dass es normalerweise die gewünschte Reaktion eines Menschen ist, einem leidenden Tier, wie in diesem Falle der Schildkröte, zu helfen. Daher kann er nicht verstehen, wieso er einem Tier nicht helfen würde und ist somit nicht in der Lage eine akzeptable Antwort auf die gestellte Frage zu finden.

Moderne Systeme wie Siri, Google Assistant und Alexa setzen die Theorie, die Kuki, Blenderbot und ihren Vorgängern zu Grunde liegt in die Praxis um. Sie wurden so entwickelt, dass sie nach Antworten auf Benutzeranfragen suchen, in dem sie Sprache in separate Wörter, Töne und Ideen umwandeln, anstatt nach einfachen Schlüsselwörtern oder übereinstimmenden Mustern zu suchen. Alexa wurde 2014 eingeführt und kann Sprachbefehle verarbeiten, um Fragen zu beantworten oder Aktionen auszuführen (z.B. nach etwas im Internet suchen, Musik abspielen, Podcasts streamen, Smart Home Produkte steuern und vieles mehr).

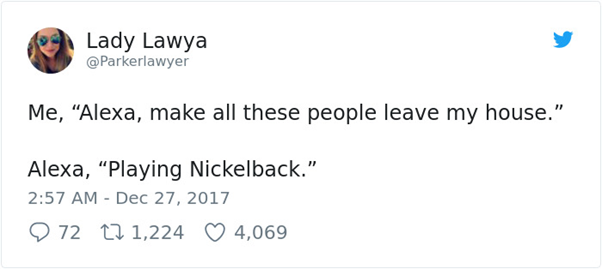

Trotzdem ist Alexa hochspezialisiert. Sie kann eine gute Leistung erbringen, solange die Benutzer:Innen nicht zu weit aus der Komfortzone abweichen. Dann macht sie oft keinen Sinn (was zu ziemlich komischen Situationen führen kann, wie hier unten im Bild).

[Lady Lawya @Parkerlawyer

Ich: “Alexa, bring die Leute dazu nach Hause zu gehen.”

Alexa:, “Nickelback wird abgespielt.”]

Gegenwärtig werden menschenähnliche Agenten:innen von Unternehmen immer häufiger für Kundendienst-, Marketing- oder Tech-Support verwendet. Sie kommen in vielen verschiedenen Formen vor, von einfachen Wörtern auf einer Webseite wie bei Eliza bis hin zu einem Chatbot mit einem virtuellen Avatar wie Kuki und Blenderbot. Und manchmal, im Falle eines echten Roboters wie Sophia, haben sie sogar einen Körper, was uns dem Jahr 2049 immer näher bringt. Diese fast menschenähnlichen Agenten:innen übernehmen oft Rollen, die sonst von menschlichen Mitarbeitern erfüllt werden würden.

Beispiele aus der Praxis sind Chatbots in Schulen, die den Schülern Sprachen beibringen, Avatare, die Produkte online empfehlen und Roboter, die älteren Menschen in medizinischen Einrichtungen helfen.

Obwohl diese Agenten:innen noch weit davon entfernt sind, als wirklich menschlich wahrgenommen zu werden, bemüht man sich sie immer menschlicher zu machen etwa durch Gesten, Kopfbewegungen, Rumpfbewegungen und Mimik. Unternehmen experimentieren sogar damit, dass sie sich für ihre Fehler entschuldigen, damit sie sensibler und weniger mechanisch wirken.

Zusammenfassend lässt sich sagen, dass trotz enormer technologischer Fortschritte seit den 1960er Jahren, heutige menschenähnliche Agenten:innen noch nicht menschlich genug sind um von (elektrischen) Schafen zu träumen. Mit dem Aufkommen leistungsfähigerer Computer in Kombination mit den richtigen Ressourcen ist die Zukunft jedoch näher als Sie denken.

Weiter lesen

- Cellan-Jones, R. (2014). Hawking: AI could end human race. BBC News, 2. Link

- Eden, A. H., Moor, J. H., Soraker, J. H., & Steinhart, E. (2012). (Eds.). Singularity Hypotheses: A Scientific and Philosophical Assessment. Berlin: Springer.

- MacTear, M., Callejas, Z., & Griol, D. (2016). The conversational interface: Talking to smart devices.

- Panova, E. (March 2021). Which AI has come closest to passing the Turing test? Data economy. Link

- Van Pinxteren, M. M., Pluymaekers, M., & Lemmink, J. G. (2020). Human-like communication in conversational agents: a literature review and research agenda. Journal of Service Management.

- Warwick, K., & Shah, H. (2016). Turing’s imitation game: Conversations with the unknown.

Autor: Naomi Nota

Redakteur: Sophie Slaats

Niederländische Übersetzung: Annelies van Wijngaarden

Deutsche Übersetzung: Barbara Molz

Endredaktion: Eva Poort